Zdjęcia uśmiechniętych świeżo upieczonych matek i szczęśliwych rodzin z nakładkami deklarującymi poparcie dla kandydata na prezydenta Karola Nawrockiego, wspieranego przez PiS, w ostatnich tygodniach wręcz zalały media społecznościowe. Dla jednych to wyraz autentycznego wsparcia, dla innych – coś, co budzi wątpliwości. Co kryje się za tymi fotografiami i jakie mogą być ich konsekwencje? Sprawdzamy.

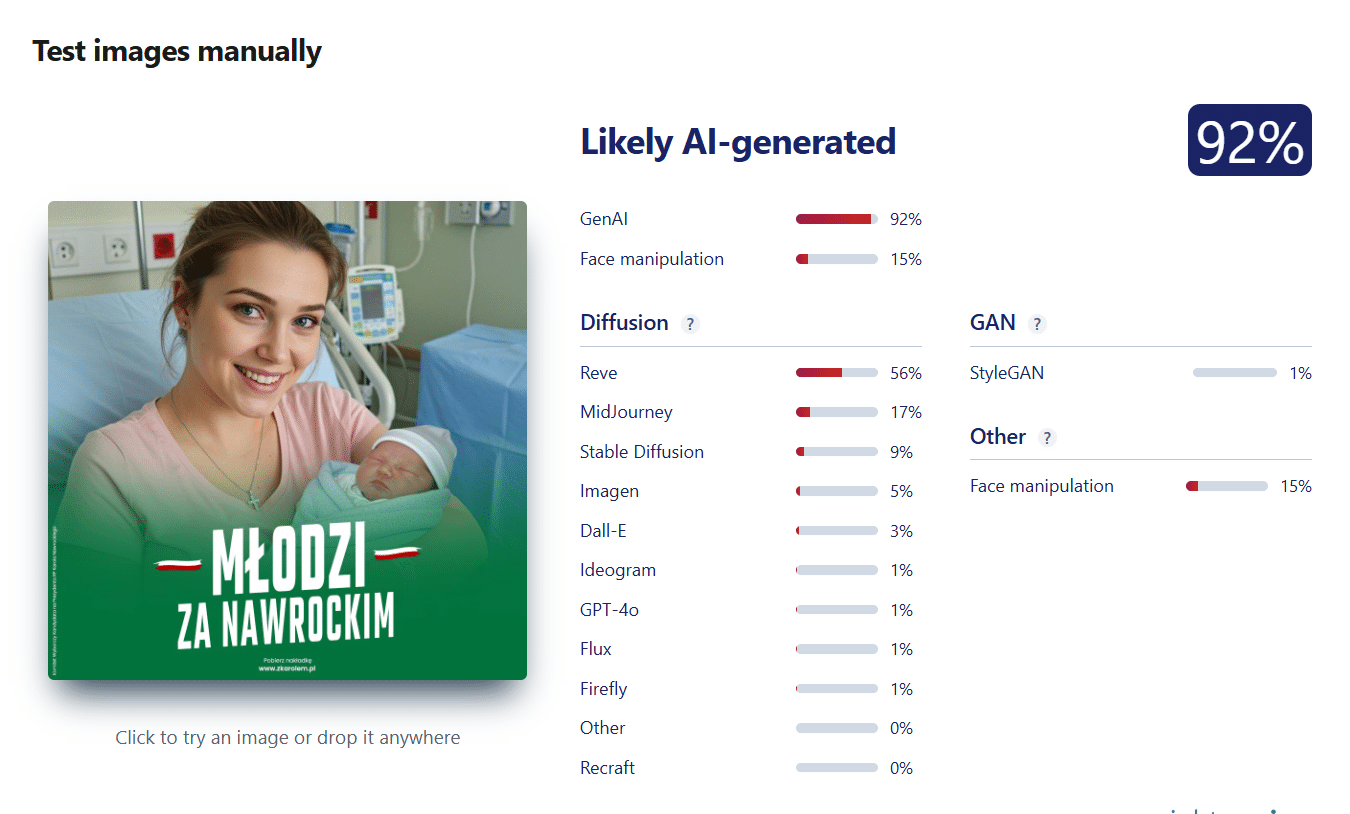

W internecie zaczęły pojawiać się zdjęcia przedstawiające różne osoby, na które nałożono nakładkę sugerującą, że popierają one kandydata na prezydenta, prezesa IPN-u Karola Nawrockiego. Jednym z takich przykładów jest wpis opublikowany na platformie X 24 marca 2025 roku. Na zdjęciu widać matkę z dzieckiem, a w tle szpitalną salę, co w połączeniu z opisem może sugerować, że kobieta dopiero co urodziła. Dzień wcześniej to samo zdjęcie udostępniła na Facebooku posłanka PiS Anna Krupka.

W komentarzach pod wpisem na X od razu pojawiły się wątpliwości co do tego, czy zdjęcie jest prawdziwe. Jedna z osób zauważyła, że kobieta nie wygląda, jakby dopiero co miała urodzić dziecko. „Kobieta i dziecko wyglądają »doskonale« – skóra jest nieskazitelna, a scena ma nienaturalnie gładki, wyretuszowany wygląd, typowe dla generowanych przez AI obrazów” (pisownia poprawiona) – wskazuje jedna z użytkowniczek. Inni zauważyli, że coś jest nie tak z gniazdkami elektrycznymi widocznymi na drugim planie zdjęcia. „Trwają poszukiwania wtyczki, która pasuje do tego gniazdka” – ironizuje jeden z użytkowników.

Fałszywe zdjęcia popierające Nawrockiego

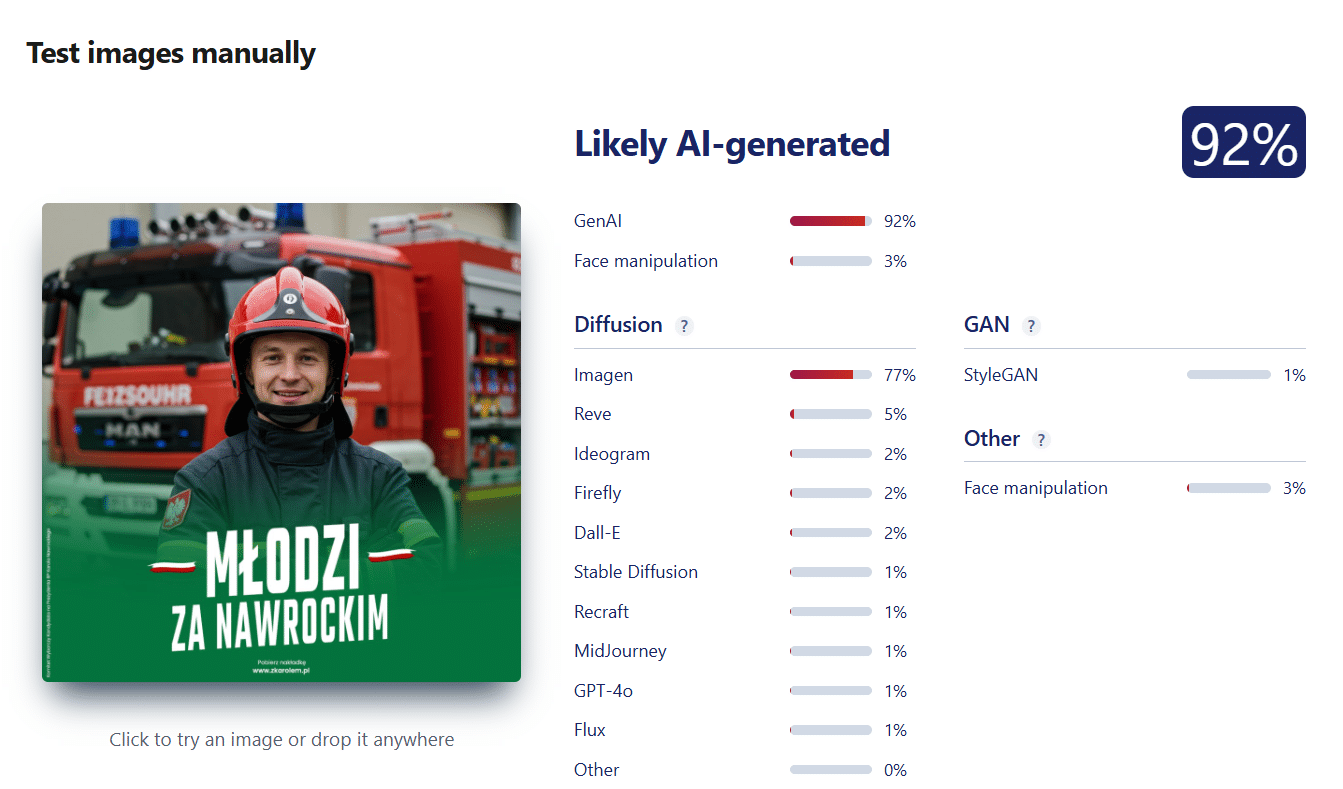

Rzeczywiście po przesłaniu fotografii do narzędzia weryfikacyjnego Sightengine okazuje się, że na 92 procent została ona wygenerowana przez sztuczną inteligencję. Choć zdjęcie sprawia wrażenie niezwykle realistycznego, wystarczy przyjrzeć się detalom w tle, by dostrzec nieścisłości – na przykład otwory w gniazdkach elektrycznych są rozmieszczone w nietypowy sposób. Przy uważniejszym przyjrzeniu się widać też, że noworodek jest niejako doklejony na zdjęciu – kocyk nie zagina się po ramieniu mamy, cienie są źle rozmieszczone i wyglądają nienaturalnie.

Podobnych zdjęć w internecie znajduje się więcej. Jedno z nich przedstawia strażaka na tle wozu strażackiego. Już na pierwszy rzut oka widać jednak, że na pojeździe nie ma polskich napisów.

Kolejne odnalezione przez nas zdjęcia przedstawiają rodziny ubrane w regionalne stroje ludowe. Także w tych przypadkach narzędzie wskazało na ponad 90-procentowe prawdopodobieństwo wygenerowania przez sztuczną inteligencję. Jeśli przyjrzymy się dłoni jednego z chłopców trzymających kwiaty, możemy zauważyć, że jego palce są rozmyte i nienaturalnie ułożone.

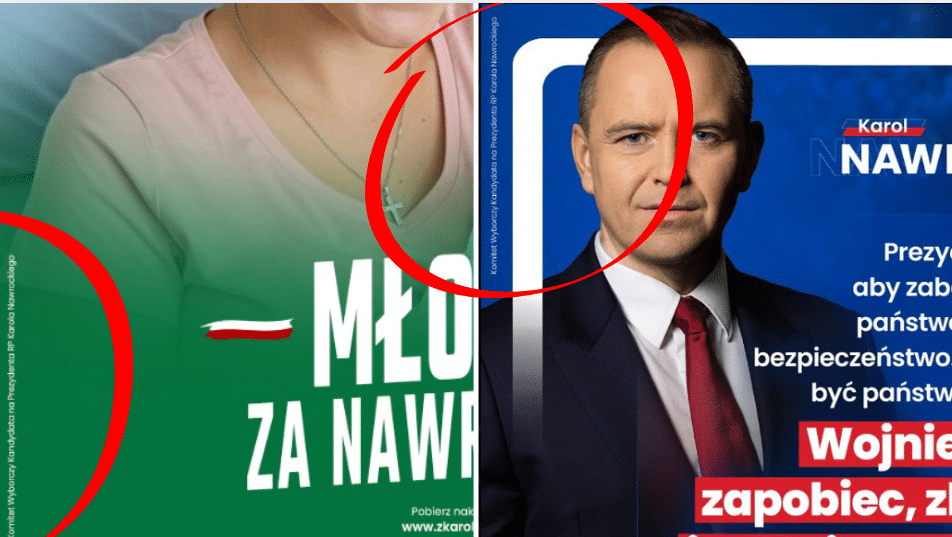

Zdjęcia te mają prawdopodobnie na celu wsparcie kampanii Karola Nawrockiego, ale w rzeczywistości mogą jej poważnie zaszkodzić. Nakładki są generowane na stronie promowanej przez sztab kandydata – https://www.zkarolem.pl – i automatycznie opatrywane podpisem „Komitet Wyborczy Kandydata na Prezydenta RP Karola Nawrockiego”. Problem w tym, że użytkownicy zaczęli wykorzystywać te oficjalne nakładki do publikowania zdjęć wygenerowanych przez AI. W efekcie fałszywe obrazy zyskują pozory autentyczności i są jednoznacznie kojarzone z kampanią kandydata wspieranego przez PiS. Przykład podpisów poniżej:

Uwaga na zdjęcia AI

Jak rozpoznać, że zdjęcie w rzeczywistości zostało wygenerowane przez sztuczną inteligencję? Warto zwrócić uwagę na kilka charakterystycznych cech. Są to przede wszystkim: nienaturalnie gładka skóra postaci, subtelne asymetrie twarzy czy zniekształcenia ubioru. W przypadku bardzo realistycznych fejków, takich jak te pojawiające się w omawianych postach, kluczowe stają się szczegóły – zwłaszcza te na dalszym planie. To tam najczęściej AI się „myli”.

Na przykład na jednym z obrazów, przedstawiającym młodą kobietę z noworodkiem, gniazdka elektryczne mają dziwnie ułożone, asymetryczne otwory. Na innym zdjęciu w tle znajduje się wóz strażacki z napisem, który nie ma żadnego sensu. Jeszcze inny przykład to rozmyta dłoń dziecka trzymającego kwiaty – szczególnie podejrzanie wygląda nienaturalny układ palców.

W przypadku dalszych wątpliwości co do analizowanej grafiki można posiłkować się narzędziami online do wykrywania obrazów AI, takimi jak Sightengine, Hive, Is It AI?, TrueMedia.org oraz AI or Not. Wykorzystują one modele wyszukujące nieregularności charakterystyczne dla algorytmów generowania obrazów. Strony te pozwalają na szybkie przeanalizowanie materiału i dają wskazówkę, czy mógł on zostać stworzony przez sztuczną inteligencję.

W tym przypadku za pomocą narzędzia Sightengine ustaliliśmy, że wiele zdjęć z nakładką popierającą Karola Nawrockiego zostało wygenerowanych przez sztuczną inteligencję. O podobnym przypadku wykorzystywania zdjęć AI w kampanii wyborczej pisały portale fact-checkingowe Fakenews.pl, Demagog oraz Konkret24.